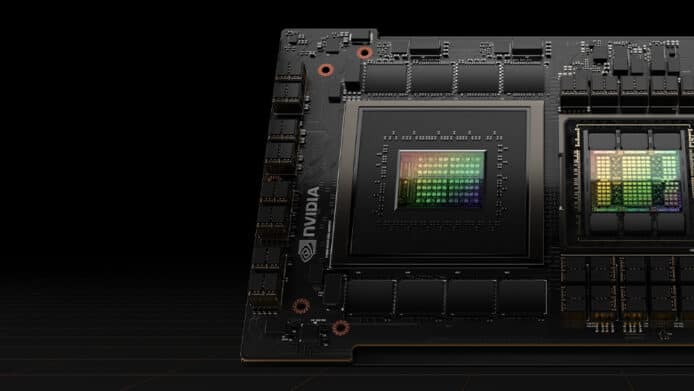

在 AI 晶片市場佔有先機的 Nvidia 在最近 AI 熱潮下相當受人矚目,他們早前就在 Computex 大會上公佈 Grace Hopper AI 晶片,可以用於建立超級運算中心。

在 Computex 大會上,Nvidia 宣佈已經開始量產 Grace Hopper 超級晶片 (GH200),這晶片結合了 Nvidia 的 Grace CPU 和 Hopper GPU 架構,使用 NVLink-C2C 互聯技術,提供高達 900GB/s 的總帶寬,比標準 PCIe Gen5 通道的帶寬高出 7 倍,可以用於進行複雜的人工智能和高性能運算工作負載。

Nvidia 總裁黃仁勳在演講中強調,目前的運算需求已經從 CPU 變成主要使用 GPU,由 GPU 組成的大型運算中心比以 CPU 組成的運算中心,在耗電和效能上都大幅優勝,配合 AI 潮流,將會是是未來的大趨勢。Google Cloud、 Meta、Microsoft 等大型科技企業都將成為採用配備 GH200 Grace Hopper 的 DGX GH200 伺服器產品的首批客戶,預計將會在今年稍後開始出貨。

來源:Nvidia

分享到 :

最新影片