網站 MacRumors 日前發現,Apple 將 CSAM 相關內容從來官網「兒童安全」頁面移除,認為這個掃描用戶 iCloud 相片庫舉措,可能因為受到網民和關注組織的激烈反彈而有變卦。CSAM 是兒童性虐待材料的英文縮寫,Apple 今年 8 月表示打算推出新功能,目的是要保護兒童免受性傷害。

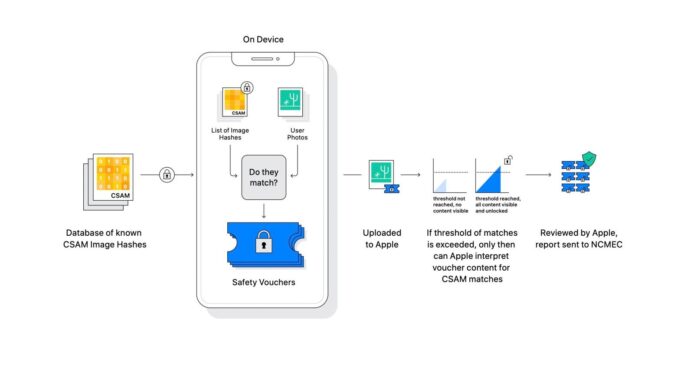

有關 Apple 防範 CSAM 的措施,包括當發出或接收到露骨相片和訊息時,或透過 Siri 或 Search 搜尋 CSAM 相關內容時,系統會向兒童用戶和家長發出警告。整個計劃最具爭議的則是 Apple 會掃描用戶上載到 iCloud 的圖片,假如發現與 CSAM 有關,就會以真人鑑定內容,再向相關機關舉報。此舉被網民和民權關注團體指侵犯私隱,同時亦憂慮會被政府作為監控的手段。

早前 iOS 15.2 正式版開放升級,防範 CSAM 的 Message 訊息兒童保護功能亦隨之推出,但掃描 iCloud 的計劃則未有實行,加上 Apple 將官網的 CSAM 相關內容移除,引來 Apple 放棄計劃的揣測。Apple 發言人強調計劃只是押後,因為他們聆聽網民、用戶、相關組織和專家意見後,需要更多時間作出調整和改善,再推出相當重要的兒童保護功能。

來源:macrumors

unwire.hk Mewe 專頁: https://mewe.com/p/unwirehk

分享到 :

最新影片