該經 Apple 官方證實,蘋果可能會在 2021 年底時開始掃描 iCloud 照片庫找出潛在的虐待兒童照片,儘管這新功能具有爭議性不過官方還說明不會僅限於新上傳。上週宣布,即將推出的功能將依靠人工智能自動標記兒童性虐待媒體 ( CSAM ),此舉引起一些隱私權倡導者的關注。

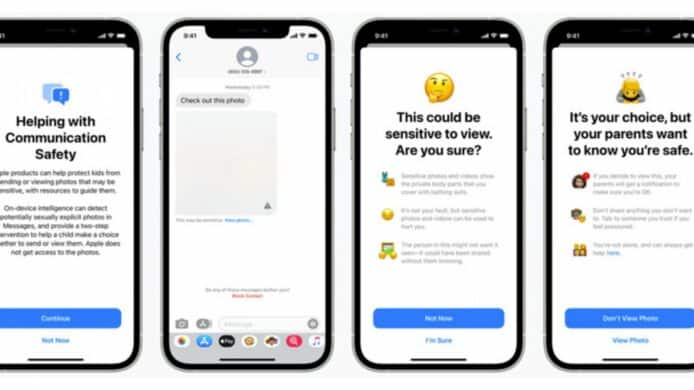

部分爭議源於蘋果公司決定同時宣布兩款以兒童保護為重點的產品。除了 iCloud 照片掃描系統之外,Apple 還會為父母提供在孩子的 Messages 對話中自動模糊潛在令人反感的圖像功能。外界擔心除了 CSAM 以外的圖片都會被掃描,嚴重影響個人私隱與及令自己個人資料變得不安全。

據 Apple 稱這功能要到今年年底才會開始投入使用,意味著屆時就會隨著 iOS 15、iPadOS 15、watchOS 8 和 macOS Monterey 一起發布。不過這似乎並不意味著從現在到那時上傳到 iCloud 照片的圖像,或者確實在新系統發布之前上傳到 iCloud 的圖像不會被掃描,已經上傳到 iCloud 照片的圖像也將被處理。

雖然新功能可能被設計為自動發現 CSAM 內容,但是無法直接向執法部門報告。蘋果強調雖然有義務向有關當局報告我們了解到的任何情況,但任何標記的事件都將首先由人工審核檢查,只有在審查過程確認後才會進行報告。

來源:The Verge

—

新增 : unwire.hk Mewe 專頁 : https://mewe.com/p/unwirehk

分享到 :

最新影片